25 sep Hemsidor 2017 och de vanligaste felen inom sökmotoroptimering (SEO) [Infografik]

Det är en mer eller mindre komplex process att genomföra en revision av en hemsidas sökmotoroptimering. Processen är egentligen en löpande process och omfattar massor av kontrollpunkter och olika kunskaper. Hemsidans storlek och syfte påverkar starkt graden av komplexitet.

Därför kan det vara en svår uppgift att hålla efter hemsidan så den hela tiden är kraftfull och välmående. För det finns inga perfekta hemsidor utan något utrymme för förbättringar.

Mot bakgrund av det kan man undra vilka frågor som ska prioriteras. Vilka är de vanligaste felen som hemsidor har inom sökmotoroptimering?

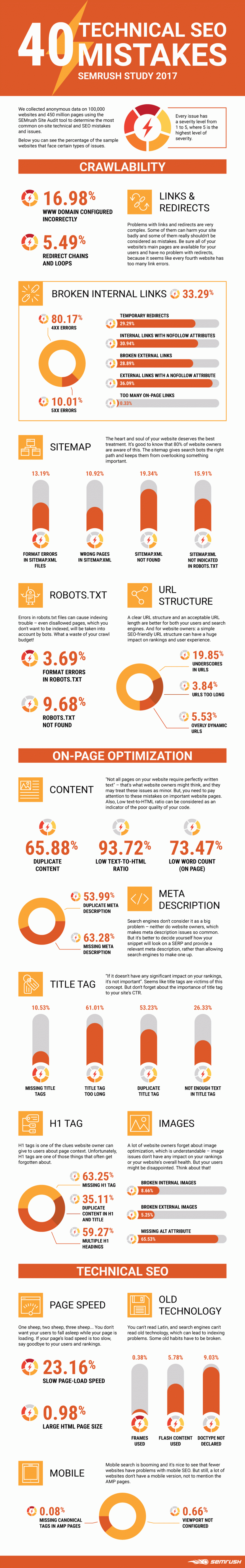

Det har SEMRush tagit reda på genom att använda sitt revisionsverktyg för hemsidor. SEMRush samlade in anonym data från 100 000 hemsidor och 450 miljoner webbsidor. Sedan undersökte SEMRush utifrån 40 kontrollpunkter hur varje hemsida och webbsida utförde, indelat i tre grupper:

Genomsökningsbarhet – Möjligheten för en sökmotor att krypa igenom hela textinnehållet på hemsidan, enkelt navigera till var och en av webbsidorna, utan att stöta på en oväntad återvändsgränd

Teknisk SEO – Konfigurationer som kan implementeras på hemsidan och servern (t ex sidelement, HTTP-rubriksvar, XML Webbplatskartor, omdirigeringar, metadata etc.).

På sidan SEO – Övningen som går ut på att optimera enskilda webbsidor i syfte att rankas högre och tjäna mer relevant trafik via sökmotorer. På sidan SEO hänvisar både innehållet och HTML-källkoden till en sida som kan optimeras.

Som en del av analysen finns det även med en dimension som heter ”Problemets allvarlighet”. Varje kontrollpunkt har tilldelats en allvarlighetsgrad från 1 till 5 där 5 är högsta allvarlighetsgrad. Orsaken bakom allvarlighetsgraden är att vissa fel uppstår mycket sällan, men kan ha en hög allvarlighetsgrad.

Två tredjedelar av de undersökta hemsidorna hade duplicerat innehåll, en tredjedel hade brutna interna länkar och 23 % hade långsamma laddningstider.

Läs mer i infografiken som följer.